El método de Newton-Raphson es un método abierto, en el

sentido de que no está garantizada su convergencia global. La única manera de alcanzar

la convergencia es seleccionar un valor inicial lo suficientemente cercano a la

raíz buscada. Así, se ha de comenzar la iteración con un valor razonablemente

cercano al cero (denominado punto de arranque o valor supuesto). La relativa

cercanía del punto inicial a la raíz depende mucho de la naturaleza de la

propia función; si ésta presenta múltiples puntos de inflexión o pendientes

grandes en el entorno de la raíz, entonces las probabilidades de que el

algoritmo diverja aumentan, lo cual exige seleccionar un valor puesto cercano a

la raíz. Una vez que se ha hecho esto, el método linealiza la función por la

recta tangente en ese valor

supuesto. La abscisa en el origen de dicha recta será, según el método, una

mejor aproximación de la raíz que el valor anterior. Se realizarán sucesivas

iteraciones hasta que el método haya convergido lo suficiente.

La función ƒ es mostrada en azul y la línea tangente en rojo. Vemos que xn+1 es una mejor aproximación que xn para la raíz x de la función f.

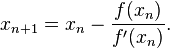

Sea f: [a, b] -> R función

derivable definida en el intervalo real [a, b]. Empezamos con un

valor inicial x0 y definimos para cada número natural

Donde f ' denota la derivada de f.

El orden de convergencia de

este método es, por lo menos, cuadrático.

Existen numerosas formas de evitar este problema, como

pudieran ser los métodos de aceleración de la convergencia tipo Δ² de Aitken o el método de Steffensen.

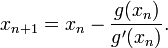

Evidentemente, este método exige conocer de antemano la

multiplicidad de la raíz, lo cual no siempre es posible. Por ello también se

puede modificar el algoritmo tomando una función auxiliar g(x) = f(x)/f'(x),

resultando:

Su principal desventaja en este caso sería lo costoso que

pudiera ser hallar g(x) y g'(x) si f(x)

no es fácilmente derivable.

Por otro lado, la convergencia del método se demuestra

cuadrática para el caso más habitual en base a tratar el método como uno de

punto fijo: si g '(r)=0, y g''(r) es distinto de 0,

entonces la convergencia es cuadrática. Sin embargo, está sujeto a las

particularidades de estos métodos.

Nótese de todas formas que el método de Newton-Raphson es

un método abierto: la convergencia no está garantizada por un teorema de

convergencia global como podría estarlo en los métodos de falsa posición o de bisección. Así, es

necesario partir de una aproximación inicial próxima a la raíz buscada para que

el método converja y cumpla el teorema de convergencia local.

![f\in{\mathcal{C}^2[a,b]}](http://upload.wikimedia.org/math/4/3/1/431e77df57656500ad40b43f8e531e28.png) verificando:

verificando:

para todo

para todo ![x\in{[a,b]}](http://upload.wikimedia.org/math/8/0/7/8072fabc06d85b2a880e3e1919be533b.png)

para todo

para todo ![x,y\in{[a,b]}](http://upload.wikimedia.org/math/4/a/c/4ac237fa866f0eda64ebd6a1067df6c6.png)

![s\in{[a,b]}](http://upload.wikimedia.org/math/d/e/e/dee2231647a98cfdaba82523c5914455.png) tal que

tal que  por lo que la sucesión converge a s.

por lo que la sucesión converge a s.Se puede demostrar que el método de Newton-Raphson tiene convergencia cuadrática: si

es raíz, entonces:

es raíz, entonces: .

Esto significa que si en algún momento el error es menor o igual a 0,1,

a cada nueva iteración doblamos (aproximadamente) el número de

decimales exactos. En la práctica puede servir para hacer una estimación

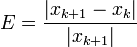

aproximada del error:

.

Esto significa que si en algún momento el error es menor o igual a 0,1,

a cada nueva iteración doblamos (aproximadamente) el número de

decimales exactos. En la práctica puede servir para hacer una estimación

aproximada del error:Error relativo entre dos aproximaciones sucesivas:

Ejemplo

Consideremos el problema de encontrar un número positivo x tal que cos(x) = x3. Podríamos tratar de encontrar el cero de f(x) = cos(x) - x3.Sabemos que f '(x) = -sin(x) - 3x2. Ya que cos(x) ≤ 1 para todo x y x3 > 1 para x>1, deducimos que nuestro cero está entre 0 y 1. Comenzaremos probando con el valor inicial x0 = 0,5